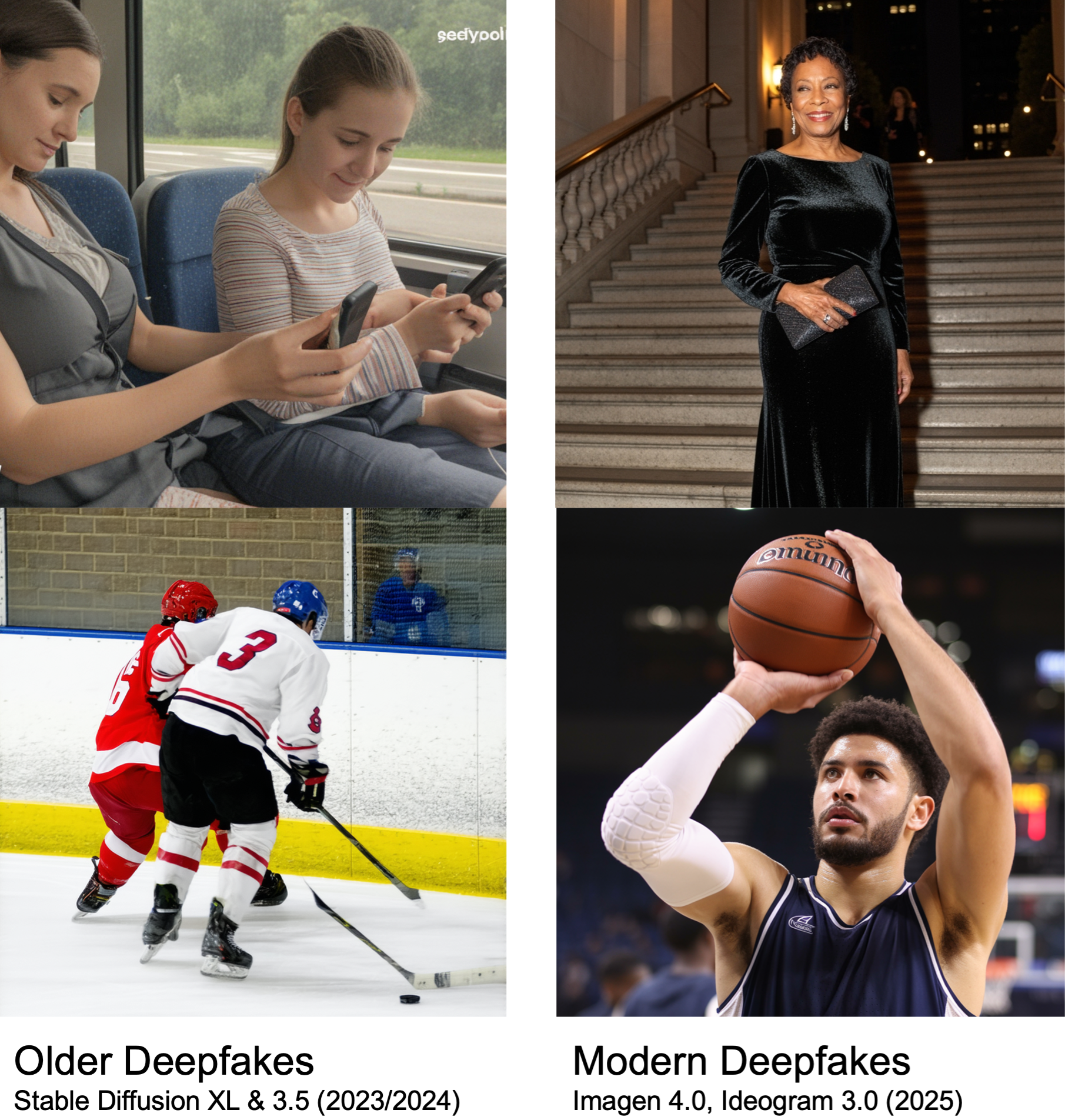

Les images générées par l'IA (ou deepfakes) sont devenues si réalistes qu'il est désormais presque impossible de distinguer une fausse image d'une vraie. Poussée par des modèles de pointe en constante évolution, la technologie moderne de génération d'images a dépassé les capacités de la plupart des détecteurs de deepfakes, rendant les internautes vulnérables à une désinformation amplifiée par des images hyperréalistes.

À mesure que notre capacité à distinguer une image réelle d'une image générée par l'IA disparaît, l'intégrité de notre écosystème d'information et notre foi en une réalité commune sont menacées : une étude récente (ainsi que nos propres observations sur la perception humaine) a révélé que les humains ne détectent les fausses images issues des modèles modernes que la moitié du temps.

Pour remédier à cela, notre nouvel article OpenFake: An Open Dataset and Platform Toward Real-World Deepfake Detection introduit un nouveau jeu de données pour entraîner la prochaine génération d'outils de détection de deepfakes.

Détecter l'invisible

Précédemment, les outils d'IA pouvaient facilement repérer les deepfakes car les premiers modèles génératifs produisaient des défauts visuels tels que du texte brouillé ou absurde, des doigts ou des dents en trop, des yeux déformés et d'autres erreurs anatomiques ou structurelles évidentes. Mais la plupart de ces problèmes ont été résolus dans les modèles les plus récents, et les outils de détection de deepfakes entraînés sur des données plus anciennes ne sont plus en mesure d'utiliser ces artefacts pour distinguer les images réelles de celles générées par l'IA moderne.

Pour s'attaquer à ce problème, nous avions besoin d'un nouveau jeu de données sur lequel entraîner des détecteurs modernes, capable d'aller au-delà de ce que l'œil nu peut voir : alors que les humains peuvent facilement être trompés par le réalisme visuel, notre méthode peut repérer de minuscules artefacts produits lorsqu'un outil d'IA génère ou met à l'échelle (upscale) des images.

Un jeu de données à jour : OpenFake

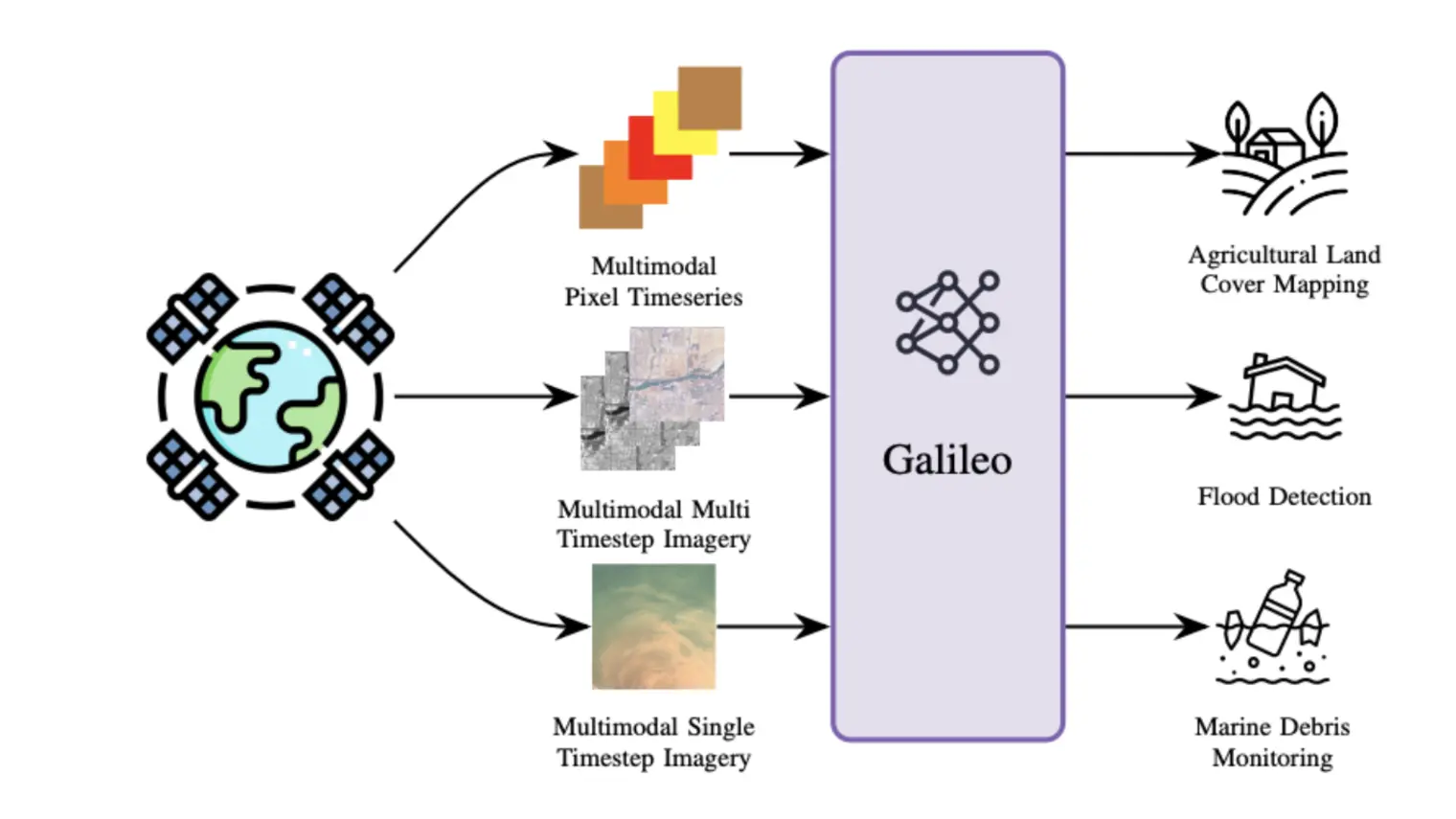

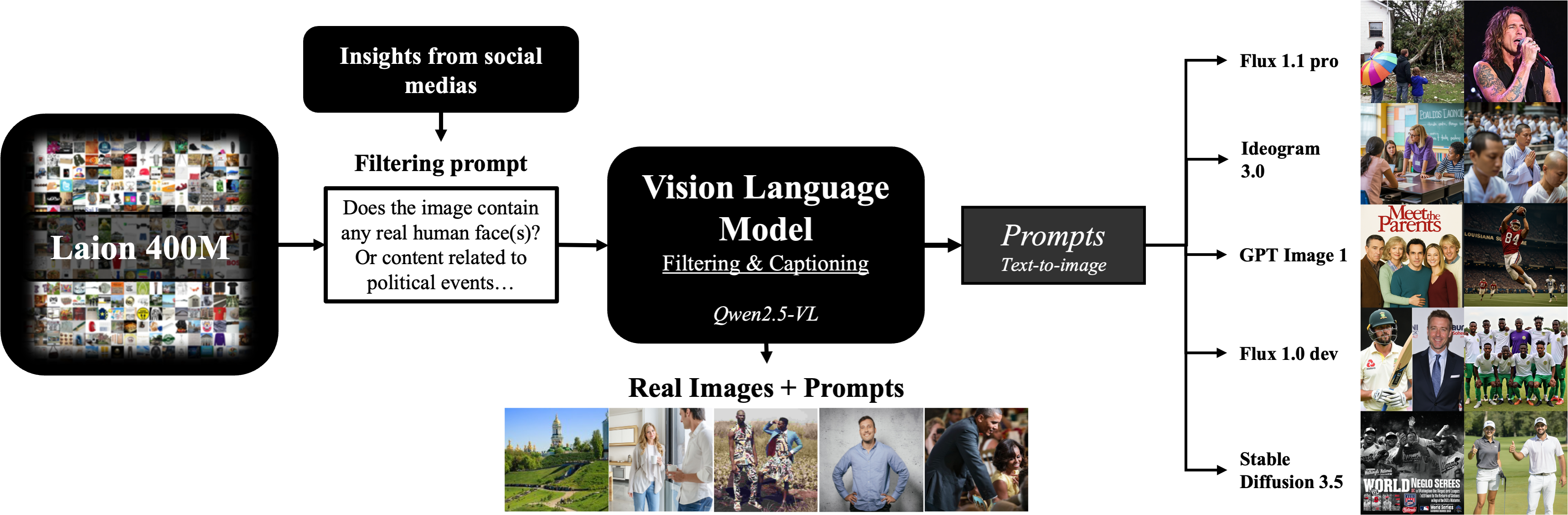

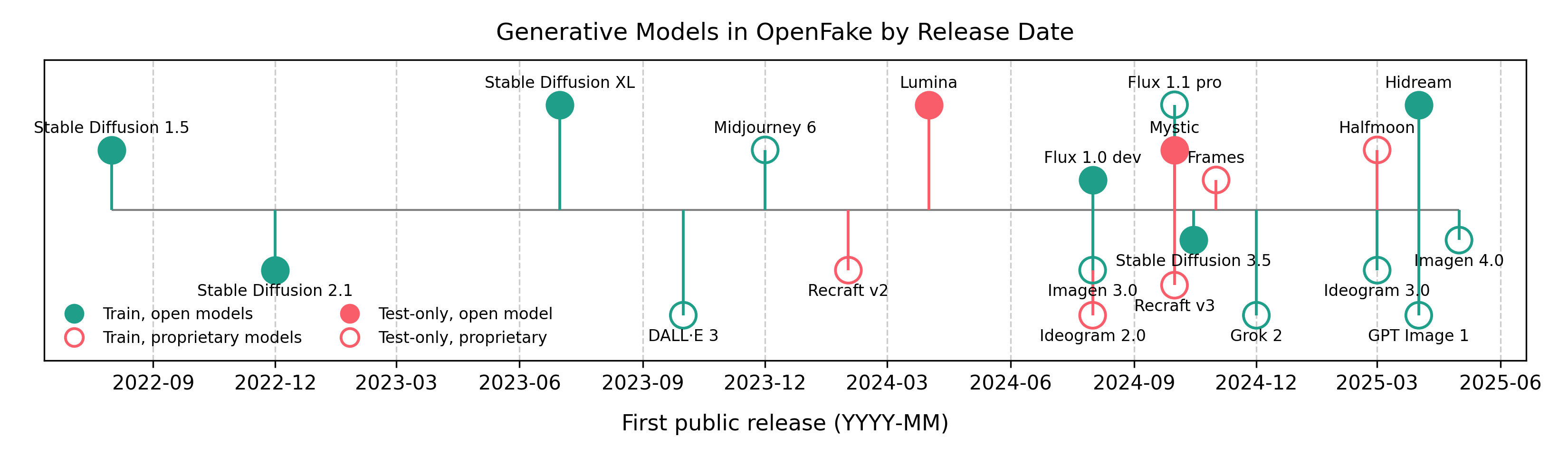

Pour élaborer le jeu de données OpenFake, nous avons collecté 3 millions d'images réelles issues du jeu de données public « Laion 400M ». Nous en avons extrait les légendes pour qu'elles servent de requêtes (prompts) afin de générer 1 million de contreparties synthétiques à l'aide d'une gamme de modèles text-to-image modernes. Le jeu de données final OpenFake est composé de 4 millions d'images, chacune associée à son prompt, sélectionnées en fonction des risques de désinformation et basées sur des modèles observés sur les réseaux sociaux.

OpenFake est le premier benchmark à intégrer des images générées par les modèles les plus récents de pointe, incluant GPT-Image-1 d'OpenAI, Imagen-4 de Google et Flux 1.1 Pro.

Meilleure généralisation dans le monde réel

Pour évaluer l'impact du jeu de données OpenFake sur les performances de détection, nous avons entraîné le même détecteur de deepfakes (basé sur l'architecture SwinV2) en utilisant trois jeux de données différents : OpenFake, GenImage et Semi-Truths. Nous avons ensuite évalué chaque modèle sur une collection, sélectionnée à la main, d'images réelles et synthétiques circulant sur les réseaux sociaux.

Le détecteur entraîné sur OpenFake a obtenu des résultats exceptionnels, confirmant nos résultats en laboratoire. En revanche, les modèles entraînés sur des jeux de données plus anciens étaient presque incapables de détecter une fausse image générée avec un modèle moderne.

Une approche participative pour l'avenir

Aucun outil de détection de deepfakes n'est à l'épreuve du temps : les générateurs d'images par IA seront mis à jour dès que des failles seront détectées, rendant un jeu de données statique inadapté aux applications futures.

C'est pourquoi nous avons introduit l'OpenFake Arena, une plateforme antagoniste participative (crowdsourced) où les utilisateurs génèrent des images synthétiques pour tenter de tromper un détecteur de deepfakes en direct. Toute image qui échappe avec succès à la détection est ajoutée au jeu de données d'entraînement. En d'autres termes, chaque fois qu'un utilisateur « bat » le modèle, il contribue aussi à le renforcer en apportant de nouveaux exemples complexes.

Les utilisateurs peuvent télécharger n'importe quelle image dans l'Arena et recevoir un résultat instantané du détecteur, ce qui en fait un outil pratique pour tester des contenus suspects en temps réel. Nous prévoyons également de publier une extension de navigateur qui permettra aux utilisateurs de vérifier n'importe quelle image sur Internet en un seul clic.

Pour rendre l'expérience plus engageante, l'Arena inclut un classement qui hiérarchise les participants en fonction de leur capacité à créer des images synthétiques convaincantes. En rejoignant l'Arena, en essayant de « casser » le détecteur et en grimpant dans le classement, les utilisateurs soutiennent directement le développement de la prochaine génération de défenses robustes contre les deepfakes.