Proceedings of the Neural Information Processing Systems

![[Figure 1: Additive decoders allow the generation of novel images never seen during training via Cartesian-product extrapolation. Purple regions correspond to latents/observations seen during training. The blue regions correspond to the Cartesian-product extension. The middle set is the manifold of images of circles. In this example, the learner never saw both circles high, but these can be generated nevertheless, thanks to the additive nature of the scene.]](/sites/default/files/inline-images/blogue%20additive%20decoders.jpeg)

Note de la rédaction : Cet article a été accepté comme présentation orale à NeurIPS 2023.

Motivation

L’apprentissage de représentations centrées sur l’objet [1, 2] vise à apprendre une représentation dans laquelle les renseignements sur les différents objets d’une scène sont encodés séparément. Cela permet de raisonner à partir de données perceptives de bas niveau, comme des images, des vidéos, etc., en apprenant des représentations structurées qui pourraient améliorer la robustesse et la généralisation systématique des systèmes de vision. Bien que plusieurs approches de segmentation fassent appel à la supervision, l’apprentissage non supervisé de représentations centrées sur l’objet qui utilisent une grande quantité de données d’images non étiquetées suscite un intérêt croissant.

![[Figure 2: Visualization of the slot renderings and how they bind to a particular object from Slot Attention.]](/sites/default/files/inline-images/GAmVi5PXcAAt0no-scaled-e1710169469858-1024x276.jpeg)

L’une des principales approches consiste à entraîner un encodeur et un décodeur afin de reconstruire les images. Par exemple, l’approche d’attention par case (“Slot Attention”) [2] permet d’apprendre un ensemble de cases (représentations) où chaque case est censée reconstruire un objet précis, comme le montre l’image ci-dessus. Ces approches ont donné des résultats impressionnants sur le plan empirique, mais la raison exacte pour laquelle elles démêlent les objets sans supervision doit être mieux comprise. Dans cet article, nous proposons une explication théorique de ce phénomène en prouvant les garanties de démêlage et d’extrapolation des décodeurs additifs, une architecture simple qui est semblable aux décodeurs centrés sur l’objet.

Démêlage et extrapolation prévisibles au moyen de décodeurs additifs

![[Figure 3: Illustrating the main assumption of the additive decoder in our data generation process.]](/sites/default/files/inline-images/GAmWq-2WEAAAIw0-scaled-e1710168579912-1024x300.jpeg)

L’architecture se compose d’un encodeur qui produit une représentation latente comprimée de l’image, qui est ensuite divisée en blocs. Ces blocs latents sont par la suite retransformés dans l’espace de l’image au moyen d’un décodeur propre au bloc. Les images propres au bloc qui en résultent sont ajoutées les unes aux autres pour obtenir l’image de sortie finale, qui est utilisée pour calculer la perte de reconstruction pour l’entraînement. Les décodeurs additifs conviennent bien aux images qui peuvent être décomposées en une somme d’images correspondant à différents objets. Il est à noter que les décodeurs additifs ne sont pas suffisamment expressifs pour modéliser l’occlusion, c’est-à-dire lorsque différents objets se chevauchent.

Démêlage

![[Figure 4: Depicting the intuition behind block disentanglement, such that rendering each latent block leads to a unique object.]](/sites/default/files/inline-images/GAmYmtlWsAEOfLV.jpeg)

Si, après l’entraînement du modèle de décodeur additif, le décodage de chaque bloc latent correspond à un objet unique, on dit que le modèle a appris des représentations démêlées. Dans le cas contraire, on dit que le modèle a appris des représentations entremêlées, comme le montre l’image ci-dessus. Notre première contribution consiste à établir de façon théorique que les décodeurs additifs qui réalisent des reconstructions parfaites auront des représentations (d’objets) démêlées si le processus de génération de l’image de réalité du terrain est également additif et suffisamment non linéaire. De plus amples détails concernant les hypothèses et la preuve sont fournis dans l’article. De plus, contrairement à plusieurs articles antérieurs sur les garanties théoriques de démêlage, nous autorisons les dépendances entre les blocs latents, qui peuvent également avoir un support de forme presque arbitraire.

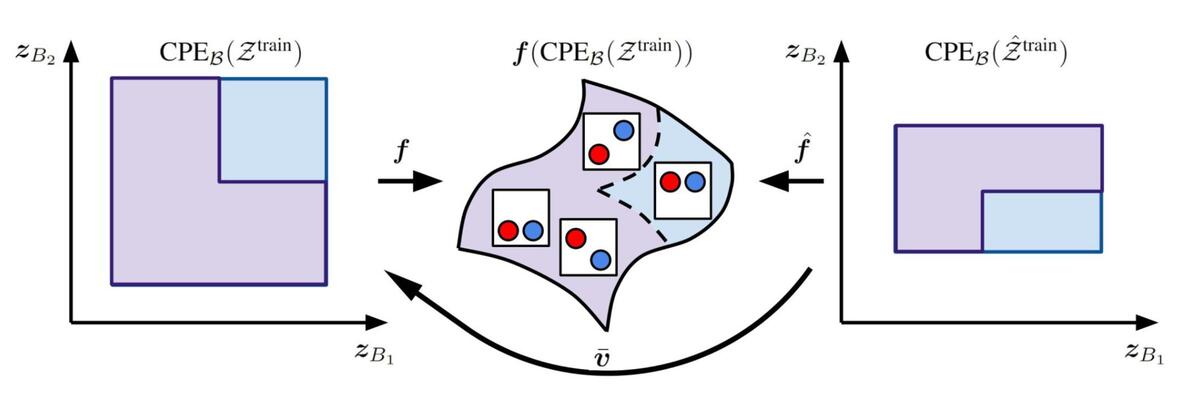

Extrapolation du produit cartésien

![[Figure 5: Illustration of the cartesian product extrapolation, where the joint support changes while the marginal support remains the same.]](/sites/default/files/inline-images/Capture-decran-le-2024-03-11-a-10.55.09-1024x421.png)

Notre deuxième contribution consiste à prouver que les décodeurs additifs peuvent effectuer une généralisation compositionnelle. La compositionnalité est un aspect important de la cognition humaine qui nous permet d’extrapoler notre compréhension à de nouveaux scénarios. Par exemple, nous pouvons imaginer à quoi ressemblerait une pomme bleue bien que nous n’ayons vu que des pommes rouges. Mais pour définir formellement cette tâche du point de vue de l’apprentissage, nous considérons la configuration présentée dans l’image ci-dessus. Étant donné le support en forme de L de la distribution latente des objets pendant l’entraînement, peut-on extrapoler au produit cartésien (carré complet) du support de la distribution latente des objets? Nous prouvons de manière formelle que le décodeur additif appris ne démêle pas seulement les objets sur le support d’entraînement, mais aussi sur la région extrapolée manquante.

Expérience

![[Figure 6: Depicting the support of the ScalarLatents dataset, where the circles move along the y-axis and we remove all images where both the circles have high y-coordinate.]](/sites/default/files/inline-images/Capture-decran-le-2024-03-11-a-10.54.59-768x411.jpg)

Pour valider empiriquement les propriétés de démêlage et d’extrapolation des décodeurs additifs, nous avons expérimenté avec l’ensemble de données des cercles en mouvement, comme le montre l’image ci-dessus. Chaque image se compose de deux cercles qui ne peuvent se déplacer que le long de l’axe des Y. Nous entraînons donc un modèle de décodeur additif avec une dimension latente d’un par bloc. En outre, nous supprimons de l’ensemble de données d’entraînement les images dans lesquelles les deux cercles apparaissent dans la moitié supérieure de l’image, ce qui permet d’obtenir un support d’entraînement en forme de L. Nous effectuons également une comparaison avec, comme point de référence, un décodeur non additif fondé sur une architecture standard d’autoencodeur.

La figure ci-dessous présente une visualisation qualitative des performances de l’approche du décodeur additif et de l’approche du décodeur non additif. Pour plus de détails concernant les résultats quantitatifs et les autres configurations, consulter l’article.

![[Figure 7: The figure in the top row shows latent representation outputted by the encoder over the training dataset and the corresponding reconstructed images of the additive decoder for the ScalarLatents dataset. The figure in the bottom row shows the same thing for the non-additive decoder. The color gradient corresponds to the value of one of the ground-truth factor, the red dots correspond to factors used to generate the images, and the yellow dashed square highlights extrapolated images.]](/sites/default/files/inline-images/GAmeQCJXgAAeGjf.jpeg)

Dans la colonne de gauche ci-dessus, nous montrons les représentations latentes apprises par l’encodeur dans l’ensemble de données d’entraînement. Dans la colonne de droite, nous présentons les images générées correspondantes. La région ombrée dans la parcelle de l’espace latent indique les exemples vus au cours de l’entraînement. Pour le décodeur additif, nous constatons que la modification du latent 1 prédit ne provoque que le changement du cercle bleu, et de manière analogue pour le latent 2. Ainsi, chaque latent prédit ne correspond qu’à un seul objet, et nous sommes en présence d’un démêlage. Il convient de noter que cela se traduit par un support latent en forme de L inversé sur les exemples d’entraînement, étant donné que l’ordre dans lequel les latents prédits correspondent aux objets peut être différent de l’ordre réel. Cependant, nous n’avons pas de démêlage dans le décodeur non additif, car la modification de l’un des latents prédits conduit à une modification des deux cercles. Par ailleurs, l’approche du décodeur additif peut extrapoler au-delà du support d’entraînement et générer de nouvelles images dans lesquelles les deux cercles ont une coordonnée Y élevée, alors que l’approche du décodeur non additif n’en est pas capable.

Enfin, nous visualisons également les reconstructions du décodeur propre au bloc des images générées par le décodeur additif dans la figure ci-dessous. Nous constatons en effet que chaque décodeur propre au bloc génère un objet unique, ce qui permet de démêler les représentations latentes apprises par le modèle.

![[Figure 8: The first row is the original image, the second row is the reconstruction and the third and fourth rows are the output of the object-specific decoders.]](/sites/default/files/inline-images/GAmb2n9XAAAy6jd.jpeg)

Conclusion

Notre article permet de comprendre pourquoi les méthodes centrées sur l’objet fonctionnent et comment elles peuvent servir à générer de nouvelles compositions d’objets. Bien que l’expressivité des décodeurs additifs soit limitée, il ne s’agit que d’une première étape. Nos travaux futurs consisteront à étendre nos résultats pour l’identification et l’extrapolation latentes prouvables dans le cas d’une addition masquée, comme dans le cas de l’occlusion d’un objet. Un article concurrent [3] établit une compositionnalité/extrapolation prouvable pour une classe plus générale de fonctions pouvant gérer l’addition masquée. Toutefois, il suppose l’accès aux vraies variables latentes, et son analyse ne montre pas comment obtenir un démêlage prouvable en même temps que la compositionnalité pour la classe proposée de fonctions de mixage. Par conséquent, la démonstration de ces résultats pour une classe plus générale de fonctions de mixage que les décodeurs additifs demeure un problème ouvert important.

De plus, nos travaux ne fournissent des garanties que pour l’extrapolation du décodeur à l’extension du produit cartésien du support d’entraînement, mais pas pour l’extrapolation de l’encodeur. Une prochaine étape importante consisterait à étendre notre analyse et notre méthode pour obtenir des garanties sur l’extrapolation de l’encodeur également. Un article récent [4] propose une fonction de perte de cohérence pour l’encodeur permettant d’atteindre le même objectif, et il serait intéressant d’approfondir cette question.

Enfin, nous sommes très enthousiastes à l’idée d’étendre cette stratégie pour comprendre la créativité dans les modèles génératifs profonds. Certains articles récents [5, 6] ont posé des hypothèses semblables à celles des décodeurs additifs pour les fonctions d’évaluation de la distribution des données. On y a montré comment cela peut être utilisé pour la compositionnalité avec des modèles de diffusion. Il s’agit donc d’une orientation intéressante et significative pour prouver des garanties semblables pour le démêlage et l’extrapolation avec des modèles de diffusion.

Références

- Burgess, Christopher P., Loic Matthey, Nicholas Watters, Rishabh Kabra, Irina Higgins, Matt Botvinick, et Alexander Lerchner. « Monet: Unsupervised scene decomposition and representation. » arXiv preprint arXiv:1901.11390 (2019).

- Locatello, Francesco, Dirk Weissenborn, Thomas Unterthiner, Aravindh Mahendran, Georg Heigold, Jakob Uszkoreit, Alexey Dosovitskiy, et Thomas Kipf. « Object-centric learning with slot attention. » Advances in Neural Information Processing Systems 33 (2020): 11525-11538.

- Wiedemer, Thaddäus, Prasanna Mayilvahanan, Matthias Bethge, et Wieland Brendel. « Compositional generalization from first principles. » Advances in Neural Information Processing Systems 36 (2024).

- Wiedemer, Thaddäus, Jack Brady, Alexander Panfilov, Attila Juhos, Matthias Bethge, et Wieland Brendel. « Provable Compositional Generalization for Object-Centric Learning. » arXiv preprint arXiv:2310.05327 (2024).

- Wang, Zihao, Lin Gui, Jeffrey Negrea, et Victor Veitch. « Concept Algebra for (Score-Based) Text-Controlled Generative Models. » Advances in Neural Information Processing Systems 36 (2024).

- Liu, Nan, Yilun Du, Shuang Li, Joshua B. Tenenbaum, et Antonio Torralba. « Unsupervised Compositional Concepts Discovery with Text-to-Image Generative Models. » arXiv preprint arXiv:2306.05357 (2023).