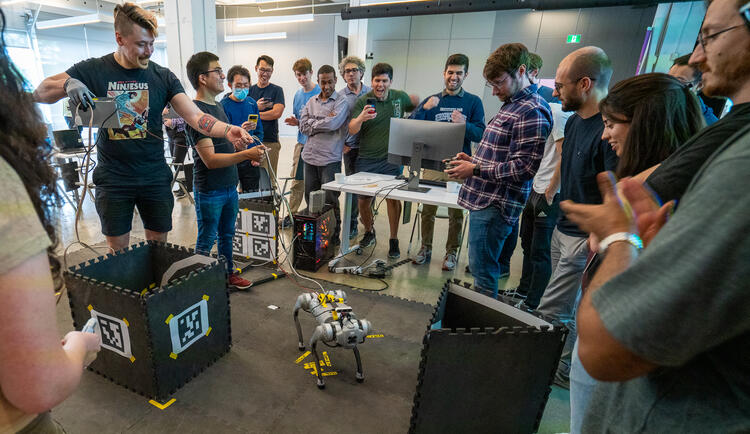

Robotique

Les robots sont utilisés dans le monde entier dans de nombreux processus industriels et s'améliorent d'année en année pour aider les humains. Les algorithmes d'apprentissage automatique améliorent les capacités de la robotique traditionnelle et sont devenus essentiels pour rendre les robots plus adaptables aux situations difficiles.