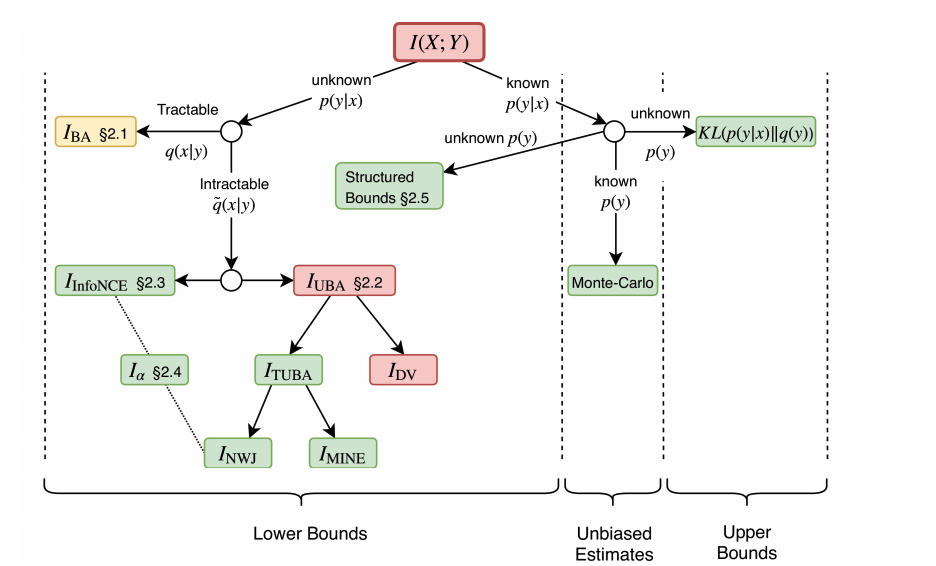

On Variational Bounds of Mutual Information

L’estimation et l’optimisation des informations mutuelles (MI) sont au cœur de nombreux problèmes liés à l’apprentissage automatique. Cependant, la limitation des IM dans les grandes dimensions est un défi. Pour établir des objectifs viables et évolutifs, des travaux récents se sont tournés vers les limites variationnelles paramétrées par les réseaux de neurones, mais les relations et les compromis entre ces limites restent flous. Dans ce travail, nous unifions ces développements récents dans un cadre unique. Nous trouvons que les limites variationnelles inférieures existantes se dégradent lorsque l’IM est grand, présentant un biais élevé ou une variance élevée. Pour résoudre ce problème, nous introduisons un continuum de limites inférieures englobant les limites précédentes et permettant de compenser avec souplesse les biais et la variance. Sur des problèmes contrôlés de grande dimension, nous caractérisons empiriquement le biais et la variance des bornes et de leurs gradients et démontrons l’efficacité de nos nouvelles limites pour l’apprentissage de l’estimation et de la représentation.