Identifying and attacking the saddle point problem in high-dimensional non-convex optimization

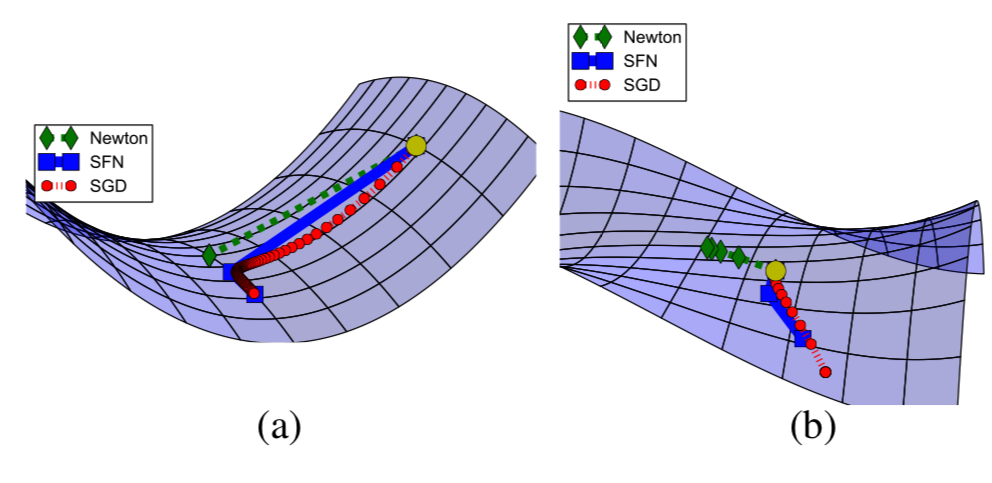

Un défi majeur dans de nombreux domaines de la science et de l’ingénierie consiste à minimiser les fonctions d’erreur non convexes dans des espaces continus de grande dimension. Les méthodes de descente de gradient ou de quasi-Newton sont presques omniprésentes pour effectuer de telles minimisations, et on pense souvent que l’une des principales sources de difficulté de ces méthodes locales pour trouver le minimum global est la prolifération de minima locaux avec une erreur beaucoup plus grande que le minimum global. Nous nous basons sur des résultats de la physique statistique, la théorie des matrices aléatoires, la théorie des réseaux neuronaux et des preuves empiriques, pour soutenir le fait qu’une difficulté plus profonde provient de la prolifération des points de selle, et non des minima locaux, en particulier lors des problèmes de grande dimension présentant un intérêt pratique. Ces points de selle sont entourés de plateaux à haute erreur qui peuvent considérablement ralentir l’apprentissage et donner une impression illusoire de l’existence d’un minimum local. Motivés par ces arguments, nous proposons une nouvelle approche d’optimisation de second ordre, la méthode de Newton sans selle, qui peut rapidement échapper aux points de selle de grandes dimensions, contrairement aux méthodes de descente sur gradient et de quasi-Newton. Nous appliquons cet algorithme à la formation en profondeur ou récurrente sur un réseau de neurones et fournissons des preuves numériques de ses performances supérieures en optimisation.

Reference

https://arxiv.org/abs/1406.2572