Hierarchical POMDP Controller Optimization by Likelihood Maximization

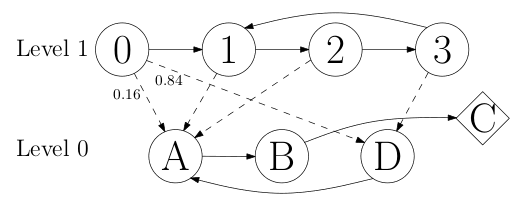

La planification peut souvent être simplifiée en décomposant la tâche en tâches plus petites organisées hiérarchiquement. Charlin et al. [4] ont récemment montré que le problème de découverte de hiérarchie pouvait être considéré comme un problème d’optimisation non convexe. Cependant, la difficulté informatique inhérente à la résolution d’un tel problème d’optimisation rend difficile l’adaptation aux problèmes du monde réel. Dans un autre domaine de recherche, Toussaint et al. [18] ont développé une méthode pour résoudre les problèmes de planification par estimation du maximum de vraisemblance. Dans cet article, nous montrons comment résoudre le problème de découverte de hiérarchie dans des domaines partiellement observables en utilisant une approche similaire du maximum de vraisemblance. Notre technique transforme d’abord le problème en un réseau bayésien dynamique à travers lequel une structure hiérarchique peut naturellement être découverte tout en optimisant la politique. Les résultats expérimentaux démontrent que cette approche évolue mieux que les techniques précédentes basées sur une optimisation non convexe.