Stochastic k-Neighborhood Selection for Supervised and Unsupervised Learning

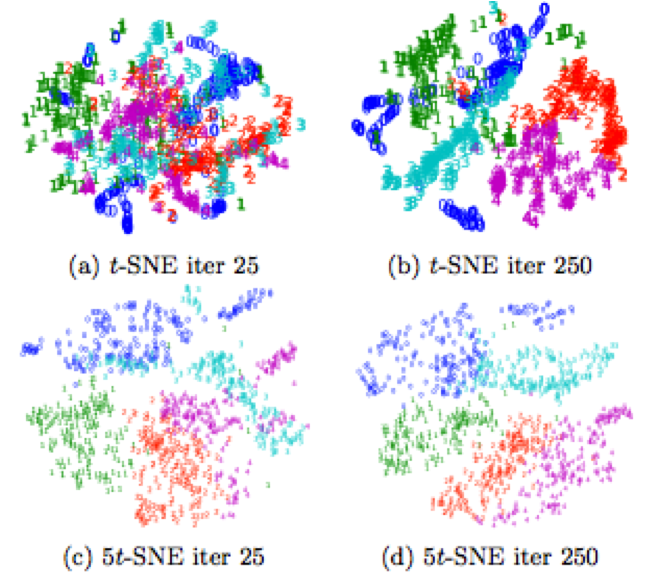

L’analyse par composantes de voisinage (ANC) est une méthode courante d’apprentissage d’une métrique de distance à utiliser dans un classifieur kNN (voisin plus proche). Une hypothèse clé intégrée au modèle est que chaque point sélectionne stochastiquement un seul voisin, ce qui rend le modèle bien justifié uniquement pour kNN avec k = 1. Cependant, les classificateurs kNN avec k> 1 sont plus robustes et généralement préférés en pratique. Nous présentons ici kNCA, qui généralise NCA en apprenant des métriques de distance appropriées pour kNN avec k arbitraire. La contribution technique principale montre comment calculer et optimiser efficacement la précision attendue d’un classifieur kNN. Nous appliquons des idées similaires dans un paramètre non supervisé pour obtenir kSNE et kt-SNE, généralisations de l’enregistrement stochastique du voisin (SNE, tSNE) opérant sur des quartiers de taille k, fournissant un axe de contrôle des imbrications permettant des régions plus homogènes et interprétables. Sur le plan empirique, nous montrons que kNCA améliore souvent la précision de la classification par rapport aux méthodes de pointe, produit des différences qualitatives dans les incorporations car k est varié, et est plus robuste vis-à-vis du bruit des étiquettes.

Reference