Learning Causal State Representations of Partially Observable Environments

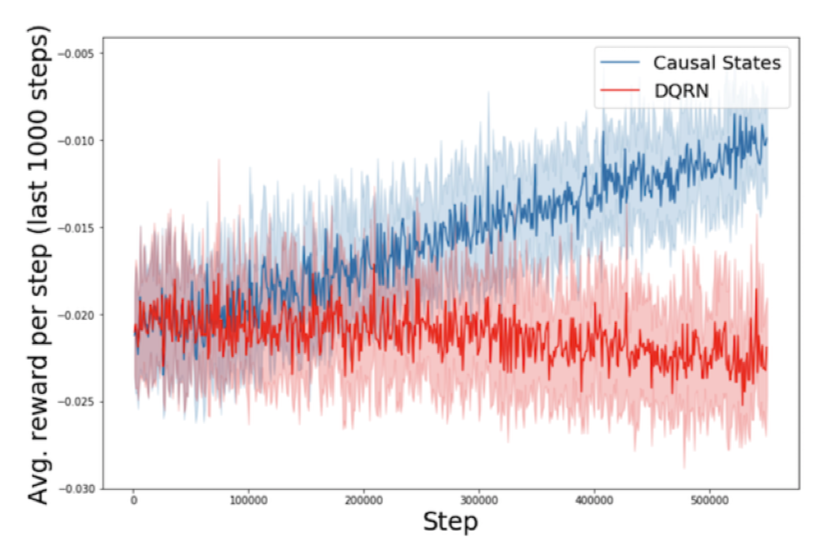

Les agents intelligents peuvent faire face à des environnements sensoriels très riches en apprenant des abstractions d’états non agnostiques. Dans cet article, nous proposons des mécanismes d’approximation des états de causalité, qui compressent de manière optimale l’historique commun d’actions et d’observations dans des processus de décision de Markov partiellement observables. Notre algorithme proposé extrait des représentations d’état causal à partir de RNNs formés pour prédire les observations ultérieures compte tenu de l’historique. Nous démontrons que ces abstractions d’états agnostiques sur des tâches apprises peuvent être utilisées pour apprendre efficacement des politiques pour des problèmes d’apprentissage par renforcement avec des espaces d’observation riches. Nous évaluons les agents en utilisant plusieurs tâches de navigation partiellement observables avec des processus d’observation discrets (GridWorld) et continus (VizDoom, ALE) qui ne peuvent pas être résolus par les méthodes traditionnelles à mémoire limitée. Nos expériences démontrent une amélioration systématique des modèles DQN et tabulaires en utilisant des représentations approximatives de l’état causal par rapport aux lignes de base DQN récurrentes formées avec des entrées brutes.

Reference

https://arxiv.org/abs/1906.10437