Greedy Layerwise Learning Can Scale to ImageNet

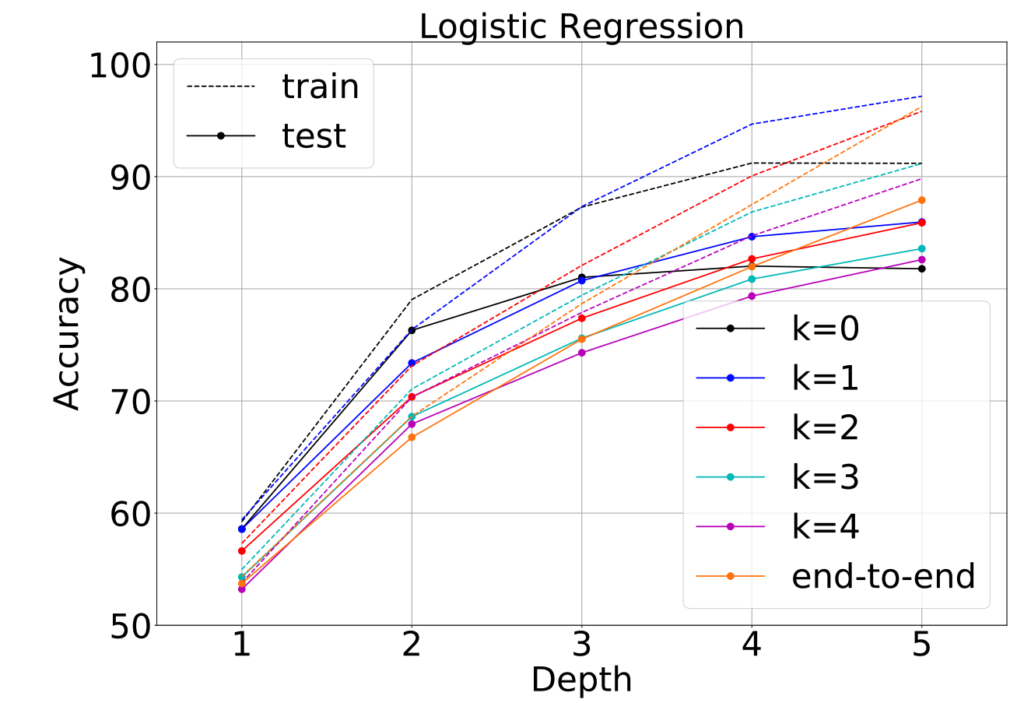

Les réseaux de neurones à couche cachée superficielle supervisés peu profonds possèdent un certain nombre de propriétés favorables qui les rendent plus faciles à interpréter, à analyser et à optimiser que leurs homologues plus profonds, mais ils n’ont pas le pouvoir de représentation. Ici, nous utilisons des problèmes d’apprentissage de couche cachée pour construire séquentiellement des réseaux profonds, couche par couche, pouvant hériter des propriétés de réseaux peu profonds. Contrairement aux approches précédentes utilisant des réseaux peu profonds, nous nous concentrons sur les problèmes pour lesquels l’apprentissage en profondeur est considéré comme essentiel au succès. Nous étudions donc les CNNs sur les tâches de classification des images à l’aide du jeu de données ImageNet à grande échelle et du jeu de données CIFAR-10. En utilisant un ensemble simple d’idées pour l’architecture et la formation, nous constatons que la résolution de problèmes auxiliaires séquentiels d’une couche cachée conduit à un CNN qui dépasse les performances d’AlexNet sur ImageNet. En étendant cette méthodologie de formation pour construire des couches individuelles en résolvant des problèmes auxiliaires de 2 et 3 couches cachées, nous obtenons un réseau de 11 couches dépassant plusieurs membres de la famille de modèles VGG sur ImageNet, et nous pouvons former un modèle VGG-11 pouvant atteindre la même précision que l’apprentissage de bout en bout. À notre connaissance, il s’agit de la première alternative compétitive à la formation de bout en bout des CNNs pouvant s’adapter à ImageNet. Nous illustrons théoriquement plusieurs propriétés intéressantes de ces modèles et réalisons une série d’expériences pour étudier les propriétés induites par cet apprentissage sur les couches intermédiaires.