Generalized Denoising Auto-Encoders as Generative Models

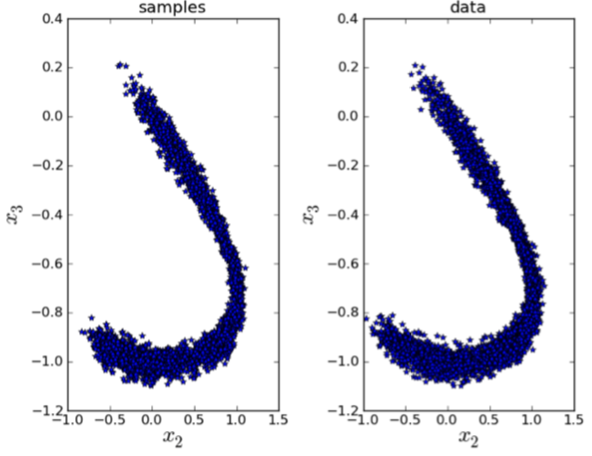

Des travaux récents ont montré comment des auto-encodeurs non liés et contractifs capturent implicitement la structure de la densité générant des données, dans le cas où le bruit de corruption est gaussien, l’erreur de reconstruction est l’erreur quadratique et les données à valeur continue. Cela a conduit à diverses propositions d’échantillonnage à partir de cette fonction de densité apprise implicitement, à l’aide de MCMC Langevin et Metropolis-Hastings. Cependant, on ne savait toujours pas comment associer la procédure d’apprentissage des auto-encodeurs régularisés à l’estimation implicite de la distribution génératrice de données sous-jacente lorsque les données étaient discrètes, ou en utilisant d’autres formes de processus de corruption et d’erreurs de reconstruction. Un autre problème est la justification mathématique qui n’est valable que dans la limite du petit bruit de corruption. Nous proposons ici une attaque différente sur le problème, qui traite toutes ces questions: corruption arbitraire (mais suffisamment bruyante), perte de reconstruction arbitraire (vue comme un «log-likelihood»), traitement des variables à valeurs discrètes et à valeurs continues, et suppression du biais en raison d’un bruit de corruption non infinitésimal (ou d’une pénalité contractive non infinitésimale).

Reference

https://arxiv.org/abs/1305.6663