Count-Based Exploration with the Successor Representation

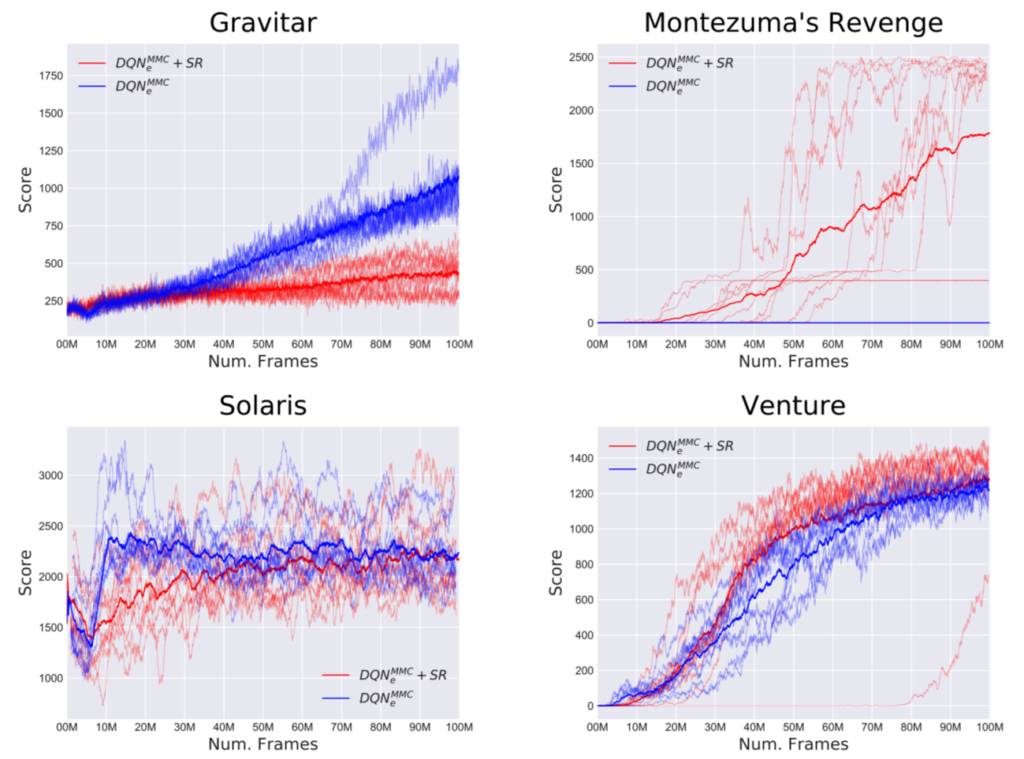

Dans cet article, nous présentons une approche simple d’exploration dans l’apprentissage par renforcement (RL) qui nous permet de développer des algorithmes théoriquement justifiés dans le cas tabulaire, mais qui peut également être étendue aux paramètres dans lesquels une approximation de la fonction est requise. Notre approche est basée sur la représentation de successeur (SR), introduite à l’origine comme étant une représentation définissant la généralisation d’état par la similarité des états successeurs. Nous montrons ici que la norme de la RS, pendant qu’elle est apprise, peut être utilisée comme prime de récompense pour encourager l’exploration. Afin de mieux comprendre ce comportement transitoire de la norme du RS, nous introduisons la représentation du successeur (SSR) et nous montrons qu’elle compte implicitement le nombre de fois où chaque état (ou caractéristique) a été observé. Nous utilisons ce résultat pour introduire un algorithme qui fonctionne aussi bien que certaines approches théoriquement efficaces en termes d’échantillonnage. Enfin, nous étendons ces idées à un algorithme RL profond et montrons qu’il réalise des performances de pointe dans les jeux Atari 2600.

Reference

https://arxiv.org/abs/1807.11622